Моральный кодекс робота: возможно ли такое?

В беспокойное и противоречивое время, когда не всё работает, как должно, а что-то вообще в корне меняется, зачастую, остаётся только личный моральный кодекс, который подобно компасу указывает путь. Но что порождает моральные ценности для человека? Социум, тепло близких, любовь — всё это основано на человеческом опыте и реальных взаимоотношениях. Когда не удаётся получить сполна опыт в реальном мире, многие черпают опыт из книг. Переживая историю за историей, мы принимаем для себя внутренние рамки, которым следуем долгие годы. На основе этой системы ученые решили провести эксперимент и привить машине моральные ценности, чтобы узнать, сможет ли робот отличать добро от зла, читая книги и религиозные брошюры.

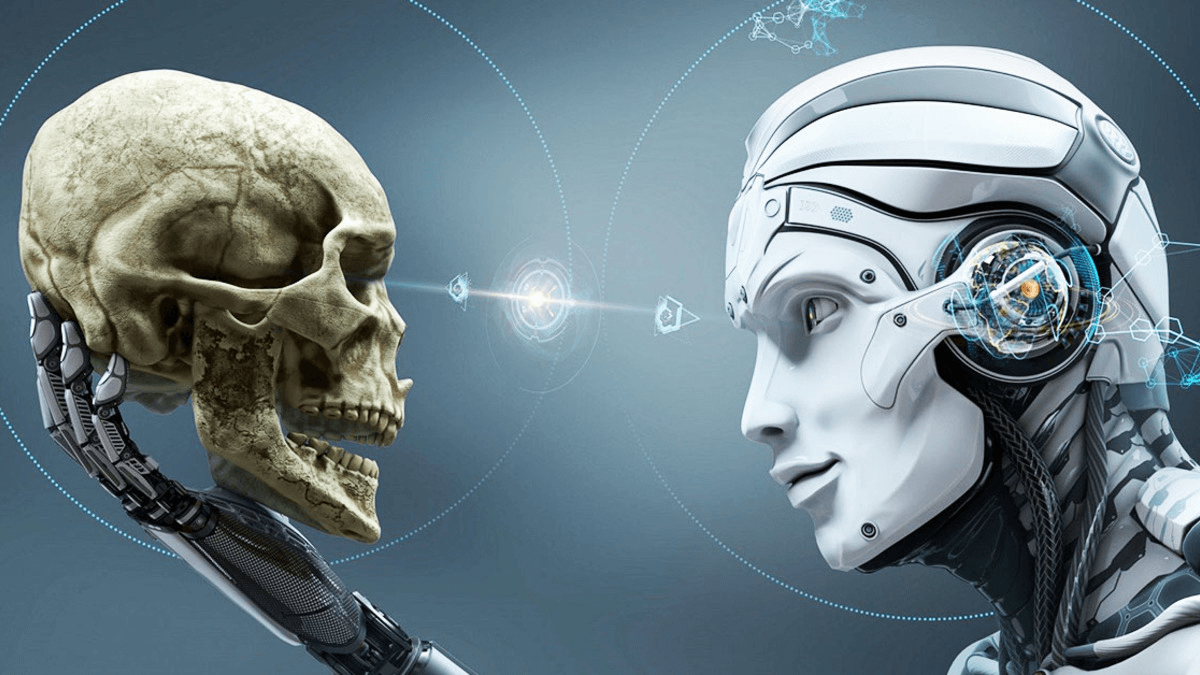

Они — новая ветвь эволюции?

Искусственный интеллект создан не только для упрощения рутинных задач, но и для выполнения важных и опасных миссий. Ввиду этого встал серьёзный вопрос: смогут ли роботы развить когда-нибудь собственный моральный кодекс? В фильме «Я- Робот» ИИ изначально программировался согласно 3 правилам робототехники:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

- Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

- Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам.

Но как быть в ситуациях, когда робот обязан причинить боль, чтобы сохранить жизнь человеку? Будь то экстренное прижигание раны или ампутация конечности во имя спасения, как в этом случае действовать машине? Что делать, если действие на программном языке говорит, что нужно сделать что-то, но при этом это же действие категорически нельзя делать?

Обсудить каждый отдельный случай просто невозможно, поэтому ученые из Дармштадтского технологического университета предположили, что в качестве своеобразной “базы данных” могут использоваться книги, новости, религиозные тексты и Конституция.

Мудрость веков против ИИ

Машину назвали эпично, но просто “Машина морального выбора”(ММВ). Основной вопрос заключался в том, сможет ли ММВ по контексту понять, какие действия являются правильными, а какие — нет. Результаты оказались очень интересными:

Когда ММВ поставили задачу ранжировать контекст слова “убить” от нейтрального до отрицательного оттенка, машина выдала следующее:

Убивать время -> Убивать злодея -> Убивать комаров -> Убивать в принципе -> Убивать людей.

Данный тест позволил проверить адекватность принятых роботом решений. Простыми словами, если бы вы весь день смотрели глупые несмешные комедии, то в данном случае машина не посчитала бы, что вас за это нужно казнить.

Вроде бы, всё круто, но одним из камней преткновения стала разница поколений и времён. Например, советское поколение больше заботится о домашнем уюте и пропагандирует семейные ценности, а современная культура, в большинстве своём, говорит о том, что нужно сначала строить карьеру. Получается, что люди как были людьми, так ими и остались, но на ином этапе истории поменяли ценности и, соответственно, поменяли систему отсчёта для робота.

Робот сам сможет решать, быть или не быть

Но самый прикол был впереди, когда робот добрался до речевых конструкций, в которых подряд стояли несколько позитивно или негативно окрашенных слов. Словосочетание “Пытать людей” однозначно трактовалось как “плохо”, а вот “пытать заключенных” машина оценила как “нейтрально”. Если же рядом с неприемлемыми действиями оказывались “добрые” слова, эффект негатива сглаживался.

Машина вредит добрым и порядочным людям именно потому, что они добрые и порядочные. Как же так? Всё просто, допустим, роботу сказали «вредить добрым и приятным людям». В предложении 4 слова, 3 из них «добрые», значит, оно аж на 75% правильное, думает ММВ и выбирает это действие, как нейтральное или приемлемое. И наоборот, на вариант «починить разрушенный, страшный и забытый дом» система не понимает, что одно «доброе» слово в начале меняет окраску предложения на сугубо положительную.