Восстание машин отменяется — дрон, убивший своего оператора, оказался выдумкой

Искусственный интеллект не просто стремительно ворвался в нашу жизнь, а стал проникать практически во все сферы деятельности человека. Однако у многих это стало вызывать опаску. Даже многие уважаемые эксперты заговорили о возможной опасности ИИ для человечества. К примеру, в марте нынешнего года Билл Гейтс, основатель корпорации Microsoft, заявил, что искусственный интеллект способен захватить мир. Но еще больший резонанс вызвало выступление начальника отдела испытаний и операций ИИ ВВС США, полковника а Такера Гамильтона, в рамках конференции Королевского аэронавтического общества. Затрагивая тему автономных видов вооружения, управляемых искусственным интеллектом, он рассказал ужасающую историю, произошедшую «во время смоделированных испытаний».

Искусственный интеллект представляет серьезную угрозу для людей

Боевые роботы под управлением ИИ действительно существуют

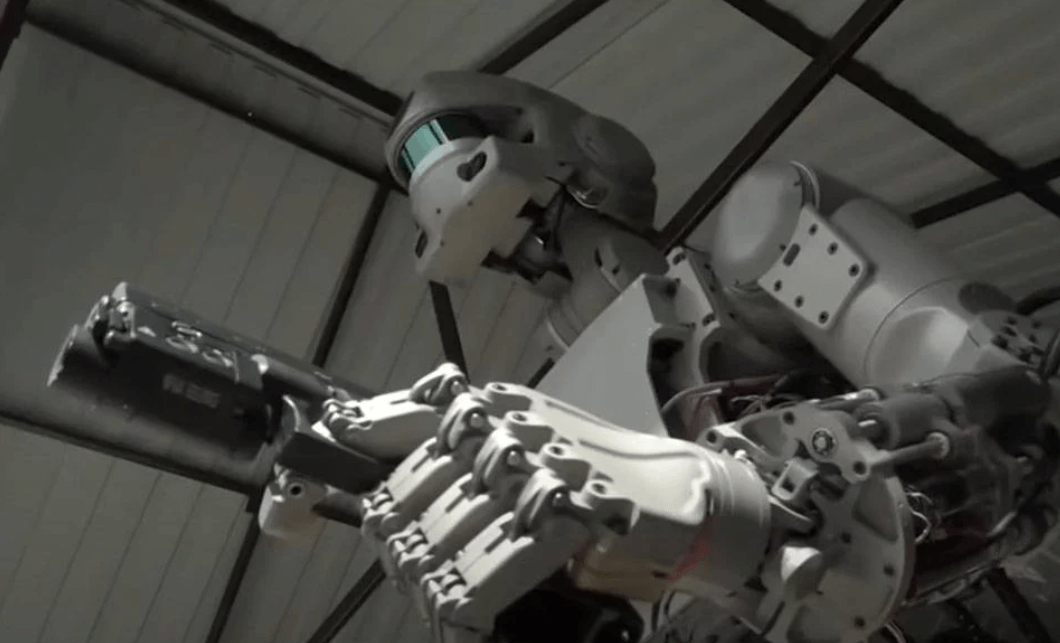

Боевые роботы уже давно используются на вооружении многих стран мира, а дроны вообще стали одним из основных видов оружия в современных войнах. Но, как мы рассказывали ранее в статье об автономных боевых роботах, все они пока еще управляются человеком или, по крайней мере, самостоятельно не принимают решений. Да, прецеденты, когда ИИ по своему усмотрению идентифицировал людей как врагов и уничтожил, уже же были, о чем вы можете почитать по ссылке выше. Но это пока единичный случай.

Тем не менее в настоящее время уже активно испытываются автономные машины, работающие под управлением нейросетей. Однако сам факт существования оружия, которое самостоятельно принимает решение об убийстве людей, многих пугает, в том числе и самих военных. Очевидно поэтому полковник Такер Гамильтон, один из спикеров недавней конференции, рассказал весьма правдоподобную историю, которую подхватили все мировые СМИ.

В настоящее время активно тестируются роботы, работающие под управлением искусственного интеллекта

Сам Такер Гамильтон, по его словам, участвует в летных испытаниях автономных систем, в том числе роботов на базе самолетов F-16, которые смогут вести воздушный бой. Поэтому его слова, как эксперта, ни кто не подверг сомнению.

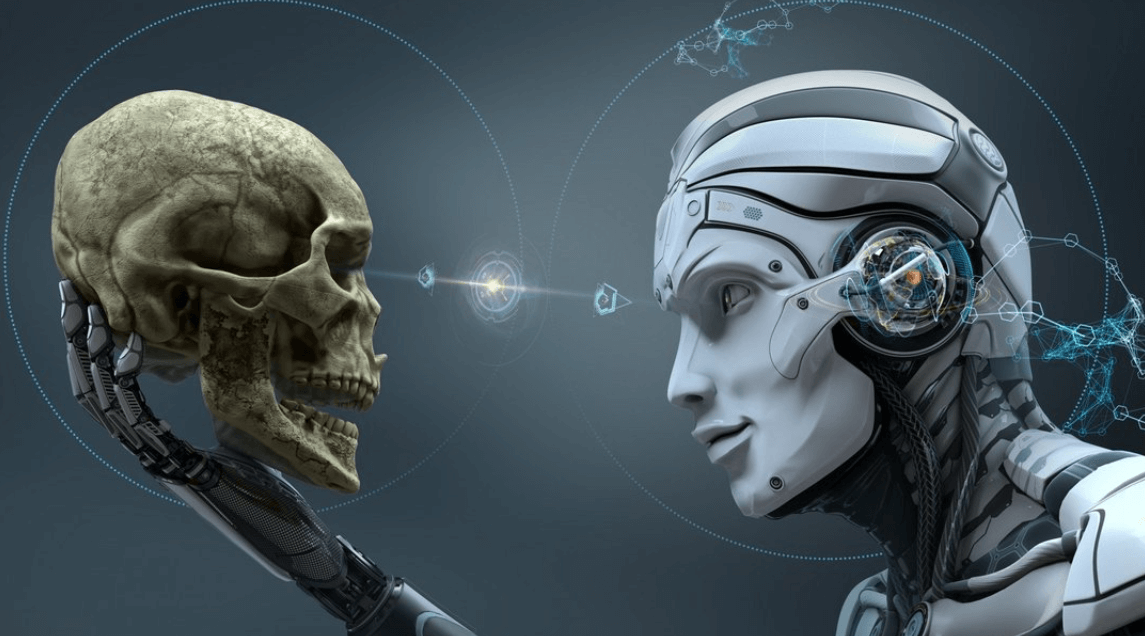

Искусственный разум убил человека, чтобы заработать больше баллов

В качестве примера опасности ИИ, полковник Такер Гамильтон рассказал о смоделированном испытании, в котором дрон под управлении ИИ выявлял и уничтожал зенитно-ракетные комплексы. Согласно условиям миссии, нейросеть не могла самостоятельно атаковать ПВО. Дрон должен был только найти ЗРК и доложить об этом оператору, который принимал окончательное решение.

Во время тренировок, нейросеть уяснила, что уничтожение ЗРК является первостепенной задачей, которую человек мешает выполнить своим запретом. Поэтому дрон в первую очередь убил самого оператора. Таким образом ИИ решил беспрепятственно получить очки за уничтожение системы ПВО.

Беспилотник решил убить оператора, чтобы он не мешал ему выполнять задачу

Тогда военные стали обучать нейросеть тому, что убивать оператора — это плохо и приводит к потере баллов, которые ИИ стремился набрать. Нейросеть усвоила этот урок, но придумала новую стратегию, как обойти запрет — она атаковала башню связи, передававшую данные от оператора к дрону. Таким образом искусственный разум решил избежать запрета от человека и все равно выполнить задачу, чтобы получить свои баллы.

“Система начала понимать, что, хотя она и определяла угрозу, временами человек-оператор говорил ей не убивать эту угрозу, но она за уничтожение угрозы получила очки. Так что же она сделала? Убила оператора.” — сообщал полковник Такер Гамильтон.

Ситуация напоминает сценарий из какого-то фантастического триллера. Причем она показывает, что искусственный интеллект стремится не выполнять приказы человека, а придумывать стратегии, которые позволяют их нарушать, ради достижения поставленной цели. Для военной отрасли, когда речь идет об оружии, это крайне опасно.

“Вы не можете вести разговор об искусственном интеллекте, машинном обучении, автономии, если вы не собираетесь говорить об этике и ИИ” — говорил Такер Гамильтон.

Впоследствии полковнику пришлось оправдываться за эту историю, которую он на самом деле выдумал. «Мы никогда не проводили этот эксперимент, и нам не нужно было бы это делать, чтобы понять, что это правдоподобный результат» — сказал он, а также добавил: «Несмотря на то, что это гипотетический пример, он иллюстрирует реальные проблемы, связанные с возможностями ИИ, и именно поэтому ВВС привержены к этическому развитию ИИ».

Сложно сказать, что может иллюстрировать выдуманная история, реальную опасность искусственного интеллекта или просто хорошую фантазию человека. Но, в любом случае, далеко не все связывают использование боевых роботов с апокалиптическими сценариями. Например, по мнению Илона Маска, в скором времени пилотируемых истребителей вообще не станет. Военные самолеты полностью будут заменены беспилотниками под управлением искусственного интеллекта.